AI工业化时代已来!告别传统ML模型,拥抱“世界模型”新纪元。LLM攻克代码、数学难题,Bitnet芯片实现ChatGPT小型化。Agent推理崛起,xLSTM提速,企业可低成本解决复杂任务。

译自:Adopt World Models Today or Fall Behind Tomorrow

作者:Nikolaos Vasiloglou

十年前,深度学习论文通常不被认为是可信的,因为它们的参考文献不会超过一年。今年,我们庆祝了在图像和文本领域奠定生成式人工智能基础的两篇论文发表十周年。在过去的十年里,我们了解到:a) 嵌入能够简洁有效地表示丰富的语义信息;b) 在大量数据上进行预训练的力量。

在参加了最新的 NeurIPS 会议(最负盛名的人工智能和机器学习会议之一)之后,我花了 100 多个小时回顾教程、会议和研讨会。以下是我对企业人工智能的主要见解。

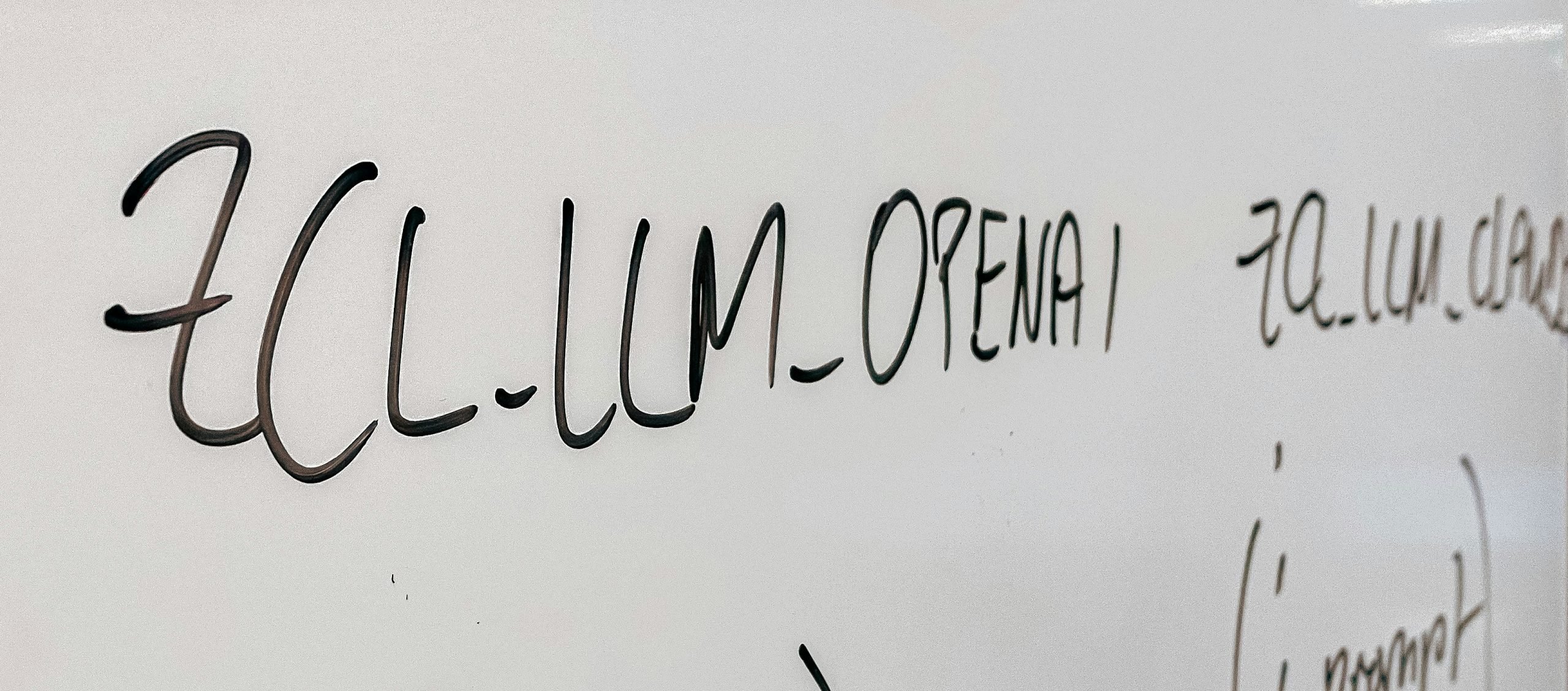

虽然像 OpenAI 这样引领大规模语言模型的 AI 先驱们已经耗尽了可用的训练数据,但预训练的方法正在扩展到文本和图像之外的其他形式。语言模型正在表格、Excel 电子表格等中进行预训练。这标志着机器学习模型的黄昏和世界模型的黎明。这些模型是代表现有知识的基础,并针对特定应用进行微调或动态情境化。

使用基于大型语言模型 (LLM) 的模型生成代码的直接商业价值证明了 NeurIPS 上大量论文的合理性。令人瞩目的是,在提高 LLM 的数学定理证明能力方面投入了同样多的研究精力。自动化数学定理证明可以追溯到上个世纪初,当时希尔伯特问是否存在一种可以自动证明定理的算法。哥德尔回答了这个问题,引导图灵奠定了计算机科学的基础。除了这项任务的学术灵感之外,教导 LLM 如何证明定理有助于我们理解如何构建更好的推理系统。正如教数学可以提高可能不一定是数学家的学生的智力一样,LLM 的数学能力有助于它们改进其他任务。

Microsoft Research 的 Lidong Zhou 在他的主题演讲中指出,很快就能看到可以容纳一万亿参数的芯片。传统模型使用浮点运算,这需要昂贵的乘法器。Bitnet 每个参数只需要 1.58 位,并且需要占用芯片表面积更小的查找表和加法器。虽然我们还没有能够构建具有 1 位参数的 Transformer,但我们仍然看到论文朝着这个方向努力,使用按位逻辑运算,从而进一步提高每单位面积的计算密度。在此之前,研究人员一直在通过微调像 LLama 和 Mistral 这样的小型模型来工作,并设法超越大型模型。Mistral 似乎在研究人员中更为普遍,因为它具有宽松的许可。为了解决更复杂的任务,将一整行组合并合并专门的 LLM。这项技术已经变得更加成熟,并且在今年的比赛中展示了实际结果。这项技术为企业提供了一种经济实惠的方式来解决复杂的任务。

作为“时间考验”奖的获得者,Ilya SuTskever 在颁奖典礼上提到,AI 巨头已经耗尽了互联网数据(化石燃料数据)。他们正在转向可以通过为推理时间分配更多计算来提高其能力的模型。这种计算将为推理智能体提供动力,这些智能体将合作解决更困难的问题。Hochreiter 在他的主题演讲中支持了这一方向,他补充说,我们需要应该以准确性换取推理速度的 LLM,这表明改进后的 LSTM(称为 xLSTM)可能就是这样一种选择。

从今年的高空视角来看,NeurIPS 标志着人工智能工业化时代的开端,它遵循了其他颠覆性技术(如电力、微芯片等)的范式。世界模型将继续存在并扩展。一次性推理成本迅速下降,达到 1 万亿 tokens(GPT-x 规模模型的训练数据大小)30,000 美元。既然我们有了快速且廉价的 LLM,基于代理的推理(也称为推理)的新时代正在兴起,开启了解决更高级任务的期望,但也存在人工智能变得更难以预测和控制的风险。